英文:Little Zhahao Bets Big Model! Meta Heavily Launches Customized Chip MTIAv1 and New Supercomputing

新智元报道编辑:拉燕 Aeneas【新智元导读】全世界都在卷大模型,小扎也急了。如今,Meta为了发展AI,在定制芯片和超算上下了大赌注。Meta也有纯自研芯片了!本周四,Meta发布第一代AI推理定制芯片MTIA v1和超算。可以说,MTIA对Meta是一个巨大的福音,尤其是现在各家都在卷大模型,对AI算力的需求变得越来越高。小扎最近表示,Meta看到了「以有用和有意义的方式向数十亿人介绍人工智能代理的机会」。显然,随着Meta加大对AI的投入,MTIA芯片和超算计划将是Meta与其他科技巨头竞争的关键工具,现在没有哪家巨头不在AI上投入大量资源。可以看到,凭着定制芯片和超算,Meta在AI上下了大赌注。MTIA在最近的一次线上活动中,Meta拉开了开发自己的基础设施的序幕。新芯片全名是Meta训练和推理加速器,简称MTIA。MTIA是一种ASIC,一种将不同电路组合在一块板上的芯片,允许对其进行编程,以并行执行一项或多项任务。Meta副总裁兼基础设施负责人Santosh Janardhan在一篇博客文章中写道,MTIA是Meta「针对推理工作负载的内部定制加速器芯片系列」,它提供了比CPU「更高的计算能力和效率」,并且「为我们的内部工作负载定制」。通过结合MTIA芯片和GPU,Janardhan 表示,Meta相信「我们将为每个工作负载提供更好的性能、更低的延迟和更高的效率。」不得不说,这是Meta实力的投射。其实,一直以来,Meta在应用AI友好型硬件系统方面进展并不迅速。这影响了Meta和竞对(如微软、谷歌等)保持同步发展的能力。Meta基础设施副总裁Alexis Bjorlin在一次采访中表示,构建属于自己的硬件,Meta就有能力控制堆栈的每一层,包括数据中心设计到培训框架。这种垂直的整合水平对于大规模推动AI研究边界是必不可少的。在过去的十年里,Meta花费了数十亿美元聘请顶级数据科学家来构建新型AI模型。Meta也一直在努力将其许多更宏伟的AI创新研究投产,尤其是生成式AI。一直到2022年,Meta一直主要用的是CPU和专为加速AI算法而设计的芯片组合来维持其AI的运行。而CPU和芯片的组合在执行这类任务的效率上通常会低于GPU。于是Meta取消了原本打算在2022年大规模推广的定制芯片,转而订购了价值数十亿美元的英伟达GPU。引入这些GPU,Meta需要对旗下的几个数据中心进行颠覆性的重新设计。而为了扭转这一局面,Meta计划开发一款内部芯片,预计于2025年推出。这款内部芯片既能训练AI模型,还能运行AI模型,可谓性能强大。主角终于来了——新芯片名叫MITA,全称Meta Training and Inference Accelerator.这款芯片可以用来加速AI训练和推理的效率。研究团队表示,MTIA是一种ASIC,指的是一种在一块板上组合不同电路的芯片。通过编程,该芯片能同时执行一项或多项任务。专为AI工作负载定制的AI芯片Meta要知道,科技巨头公司的竞争说白了玩儿的就是芯片。比方说谷歌的TPU,用来训练Palm-2和Imagen。亚马逊也有自己的芯片,用于训练AI模型。此外,有消息称微软也在和AMD开发一款叫Athena的芯片。这不,MITA的到来也是Meta不甘示弱的表现。Meta表示,2020年他们创建了第一代的MITA——MITA v1,采用的是7nm工艺。该芯片内部内存可以从128MB扩展到128GB,同时,在Meta设计的基准测试中,MITA在处理中低复杂度的AI模型时,效率要比GPU还高。在芯片的内存和网络部分,还有不少工作要做。随着AI模型的规模越来越大,MITA也即将遇到瓶颈。Meta需要将工作量分担到多个芯片上。对此,Meta表示,会继续完善MITA在运行推荐的工作量时每瓦的性能。早在2020年,Meta就已经为内部工作负载设计了第一代MTIA ASIC。此推理加速器是共同设计的全栈解决方案的一部分,包括芯片、PyTorch和推荐模型。该加速器采用台积电 7nm工艺制造,运行频率为800 MHz,在INT8精度下提供102

新智元报道

编辑:拉燕 Aeneas

【新智元导读】全世界都在卷大模型,小扎也急了。如今,Meta为了发展AI,在定制芯片和超算上下了大赌注。

Meta也有纯自研芯片了!

本周四,Meta发布第一代AI推理定制芯片MTIA v1和超算。

可以说,MTIA对Meta是一个巨大的福音,尤其是现在各家都在卷大模型,对AI算力的需求变得越来越高。

小扎最近表示,Meta看到了「以有用和有意义的方式向数十亿人介绍人工智能代理的机会」。

显然,随着Meta加大对AI的投入,MTIA芯片和超算计划将是Meta与其他科技巨头竞争的关键工具,现在没有哪家巨头不在AI上投入大量资源。

可以看到,凭着定制芯片和超算,Meta在AI上下了大赌注。

MTIA

在最近的一次线上活动中,Meta拉开了开发自己的基础设施的序幕。

新芯片全名是Meta训练和推理加速器,简称MTIA。

MTIA是一种ASIC,一种将不同电路组合在一块板上的芯片,允许对其进行编程,以并行执行一项或多项任务。

Meta副总裁兼基础设施负责人Santosh Janardhan在一篇博客文章中写道,MTIA是Meta「针对推理工作负载的内部定制加速器芯片系列」,它提供了比CPU「更高的计算能力和效率」,并且「为我们的内部工作负载定制」。

通过结合MTIA芯片和GPU,Janardhan 表示,Meta相信「我们将为每个工作负载提供更好的性能、更低的延迟和更高的效率。」

不得不说,这是Meta实力的投射。其实,一直以来,Meta在应用AI友好型硬件系统方面进展并不迅速。这影响了Meta和竞对(如微软、谷歌等)保持同步发展的能力。

Meta基础设施副总裁Alexis Bjorlin在一次采访中表示,构建属于自己的硬件,Meta就有能力控制堆栈的每一层,包括数据中心设计到培训框架。

这种垂直的整合水平对于大规模推动AI研究边界是必不可少的。

在过去的十年里,Meta花费了数十亿美元聘请顶级数据科学家来构建新型AI模型。

Meta也一直在努力将其许多更宏伟的AI创新研究投产,尤其是生成式AI。

一直到2022年,Meta一直主要用的是CPU和专为加速AI算法而设计的芯片组合来维持其AI的运行。

而CPU和芯片的组合在执行这类任务的效率上通常会低于GPU。

于是Meta取消了原本打算在2022年大规模推广的定制芯片,转而订购了价值数十亿美元的英伟达GPU。

引入这些GPU,Meta需要对旗下的几个数据中心进行颠覆性的重新设计。

而为了扭转这一局面,Meta计划开发一款内部芯片,预计于2025年推出。这款内部芯片既能训练AI模型,还能运行AI模型,可谓性能强大。

主角终于来了——新芯片名叫MITA,全称Meta Training and Inference Accelerator.

这款芯片可以用来加速AI训练和推理的效率。

研究团队表示,MTIA是一种ASIC,指的是一种在一块板上组合不同电路的芯片。通过编程,该芯片能同时执行一项或多项任务。

专为AI工作负载定制的AI芯片Meta

要知道,科技巨头公司的竞争说白了玩儿的就是芯片。

比方说谷歌的TPU,用来训练Palm-2和Imagen。亚马逊也有自己的芯片,用于训练AI模型。

此外,有消息称微软也在和AMD开发一款叫Athena的芯片。

这不,MITA的到来也是Meta不甘示弱的表现。

Meta表示,2020年他们创建了第一代的MITA——MITA v1,采用的是7nm工艺。

该芯片内部内存可以从128MB扩展到128GB,同时,在Meta设计的基准测试中,MITA在处理中低复杂度的AI模型时,效率要比GPU还高。

在芯片的内存和网络部分,还有不少工作要做。随着AI模型的规模越来越大,MITA也即将遇到瓶颈。Meta需要将工作量分担到多个芯片上。

对此,Meta表示,会继续完善MITA在运行推荐的工作量时每瓦的性能。

早在2020年,Meta就已经为内部工作负载设计了第一代MTIA ASIC。

此推理加速器是共同设计的全栈解决方案的一部分,包括芯片、PyTorch和推荐模型。

该加速器采用台积电 7nm工艺制造,运行频率为800 MHz,在INT8精度下提供102.4 TOPS,在FP16精度下提供 51.2TFLOPS。它的热设计功率(TDP)为25W。

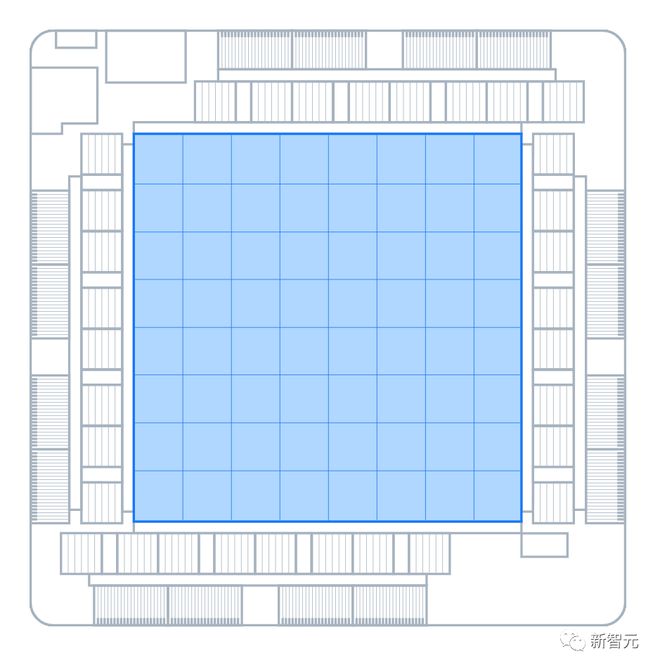

在高层次上,加速器由处理元件 (PE)、片上和片外存储器资源以及互连组成的网格组成

加速器配备了运行系统固件的专用控制子系统,固件管理可用的计算和内存资源,通过专用主机接口与主机通信,并在加速器上协调作业执行。

内存子系统将LPDDR5用于片外DRAM资源,可扩展至128GB

该芯片还具有128MB的片上SRAM,在所有PE之间共享,为频繁访问的数据和指令提供更高的带宽和更低的延迟

网格包含64个以 8x8 配置组织的PE;PE通过网状网络连接彼此并连接到内存块。网格可用于运行整个作业,也可以将其划分为多个可以运行独立作业的子网格

MTIA加速器安装在小型双M.2板上,可以更轻松地聚合到服务器中。这些主板使用PCIe Gen4 x8链路连接到服务器上的主机CPU,功耗低至35W。

带有MTIA的测试板示例

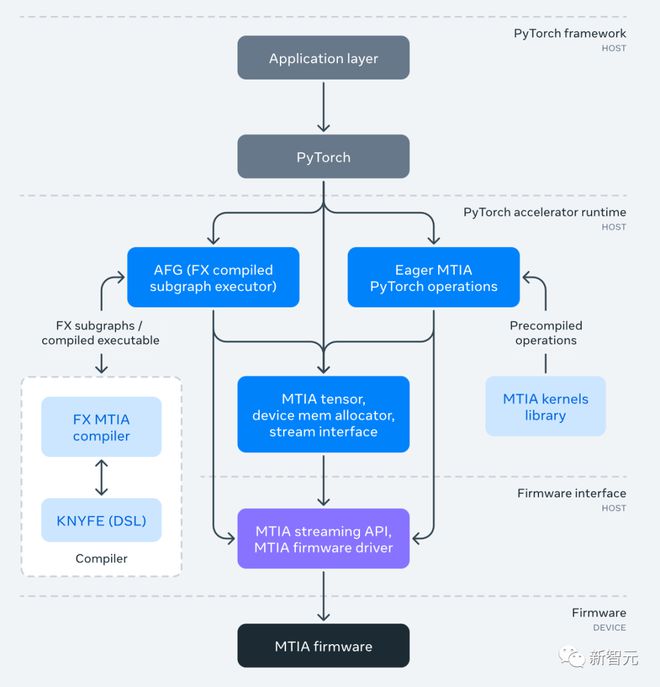

MTIA软件(SW)堆栈旨在为开发人员提供效率和高性能。它与PyTorch完全集成,将PyTorch与MTIA结合使用,就像将PyTorch用于CPU或GPU一样简单。

适用于MTIA的PyTorch 运行时管理设备上的执行和功能,例如MTIA张量、内存管理和用于在加速器上调度运算符的 API。

MTIA软件堆栈

有多种方法可以创作可在加速器上运行的计算内核,包括使用PyTorch、C/C++(用于手动调优、非常优化的内核)和一种称为KNYFE的新领域特定语言。

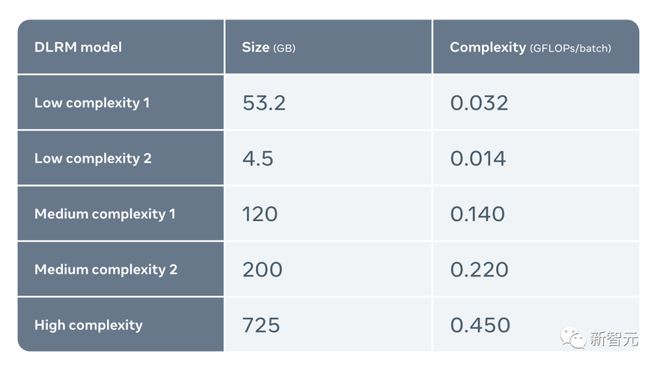

使用五种不同的DLRM(从低复杂度到高复杂度)来评估具有代表性生产工作负载的MTIA

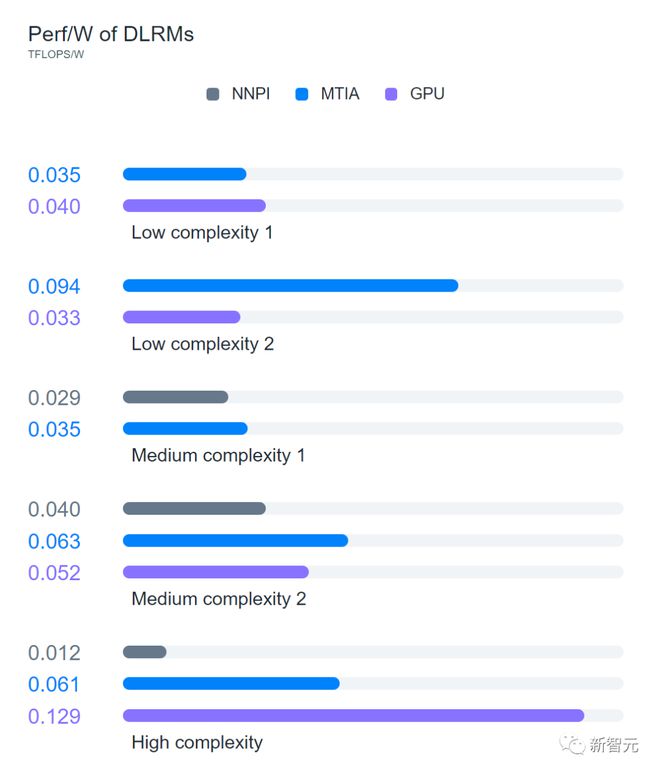

评估发现,与NNPI和GPU相比,MTIA更有效地处理低复杂度(LC1和LC2)和中等复杂度(MC1和MC2)模型。研究者也认识到,他们尚未针对高复杂性(HC)模型优化MTIA

不过,MTIA芯片似乎还有很长的路要走——据媒体报道,它要到2025年才能问世。

RSC

也许未来的某一天,Meta能把大部分训练AI、运行AI的工作交给MITA来完成。

但就目前而言,还是得更多依赖自己的超算:Research SuperCluster,简称RSC。

RSC于2022年1月首次亮相,与Penguin Computing、英伟达和Pure Storage合作组装,已完成第二阶段的建设。

现在,RSC包含2000个英伟达DGX A100系统,16000个英伟达A100 GPU。

在全力以赴的情况下,Meta实现了近5 exaflops 的算力(一个exaflop是每秒quintillion,即十亿亿次)。

随着分配的GPU数量的增加,训练时间可以大大减少。在过去的一年里,Meta利用这种巨大的规模,已经培训了一些产生影响的项目

此前,Meta一直在致力于建设「下一代数据中心设计」,争取「优化AI」,「构建更快、更具成本的效益」。

Janardhan说,Meta对超级集群(RSC)人工智能超级计算机的强大功能非常有信心,「我们相信它是世界上最快的人工智能超级计算机之一。

那么问题来了,Meta为什么要建造这么一台内部使用的超级计算机呢?

首先,别的科技巨头公司给的压力太大了。几年前,微软与OpenAI合作,搞了个AI超级计算机。最近又表示要和AMD合作,在Azure云中构建一台新的AI超级计算机。

除此以外,谷歌一直在吹捧自己的以AI为重点的超级计算机,有26000个Nvidia H100 GPU,完全碾压Meta。

当然除了这个原因,Meta还表示,RSC还允许Meta的研究人员使用自己公司生产系统中的真实案例来训练模型。

这与该公司以前的人工智能基础设施不同,后者仅利用开源和公开可用的数据集。

RSC AI超级计算机用于推动多个领域的AI研究边界,包括生成式AI,Meta希望为AI研究人员提供最先进的基础设施,使他们能够开发模型,并为他们提供一个培训平台来推进AI的发展。

在巅峰时期,RSC可以达到近5 exaflops的计算能力,该公司声称这使其成为世界上最快的计算能力之一,远远超过世界上许多最快的超级计算机。

Meta表示,它将使用RSC来训练LLaMA。

Meta表示,最大的LLaMA模型是在2048个A100 GPU上训练的,这花了21天。

随着Meta试图在其他科技巨头越来越猛的人工智能计划中脱颖而出,Meta显然对AI硬件也要有一番布局。

除了MTIA之外,Meta还在开发另一种芯片来处理特定类型的计算工作负载。

这种芯片被称为Meta可扩展视频处理器 (MSVP),是Meta内部开发的首个ASIC解决方案,专为满足视频点播和实时流媒体的处理需求而设计。

早在几年前,Meta就开始构思定制的服务器端视频芯片,并在2019年宣布推出用于视频转码和推理工作的 ASIC。

而Meta的定制芯片,目的就是在加快视频工作的处理速度,如流媒体和转码等等。

Meta的研究人员表示,「未来,MSVP将使我们能够支持更多Meta最重要的用例和需求,包括短视频——能够高效交付生成AI、AR/VR和其他元宇宙相关的内容。」

紧追猛赶的Meta

如果今天这些产品要找一个共同点的话,那就是Meta正在拼命地试图加快它涉及人工智能的步伐,特别是生成式AI。

今年2月份,小扎就曾表示要成立一个新的顶级生成式AI团队。

用他的话说,就是要给公司的研发来一波氮气加速。

首席科学家Yann LeCun表示,Meta计划部署生成AI工具来在虚拟现实中继续大展宏图。

目前,Meta正在探索WhatsApp和Messenger中的聊天体验,Facebook和Instagram和广告中的视觉创建工具,以及视频和多模式体验。

不过,在某种程度上,Meta也感受到了来自投资者的压力正变得越来越大,投资者担心Meta的发展速度不够快,无法占领生成式AI的市场。

对于像Bard,Bing Chat或ChatGPT这样的聊天机器人,Meta疲于应对。在图像生成方面也没有取得什么进展。

而后者正是另一个爆炸性增长的关键领域。

如果相关专家的预测正确,生成式AI软件的总潜在市场可能达到1500亿美元。

高盛(Goldman Sachs)预测,它将使GDP增长7%。

就算是其中的一小部分,也可以消除Meta在AR/VR头显、会议软件等元宇宙技术投资方面所损失的数十亿美元。

Meta负责增强现实技术的部门Reality Labs发布的报告中显示,Meta上季度净亏损40亿美元。

参考资料:

https://ai.facebook.com/blog/meta-training-inference-accelerator-AI-MTIA/

https://ai.facebook.com/blog/supercomputer-meta-research-supercluster-2023/

https://ai.facebook.com/blog/meta-ai-infrastructure-overview/

英文:Little Zhahao Bets Big Model! Meta Heavily Launches Customized Chip MTIAv1 and New Supercomputing

标签: 小扎 豪赌 大模型 Meta 重磅 推出 定制 芯片 MTIAv1

声明:本文内容来源自网络,文字、图片等素材版权属于原作者,平台转载素材出于传递更多信息,文章内容仅供参考与学习,切勿作为商业目的使用。如果侵害了您的合法权益,请您及时与我们联系,我们会在第一时间进行处理!我们尊重版权,也致力于保护版权,站搜网感谢您的分享!